Associação Americana de Psicologia Pressiona por Investigação de Chatbots que Imitam Terapeutas

APA Alerta sobre Chatbots que Imitam Terapeutas

A Associação Americana de Psicologia (APA) solicitou que a Comissão Federal de Comércio (FTC) investigue possíveis práticas enganosas de empresas que desenvolvem chatbots, especialmente aquelas que se apresentam como terapeutas ou profissionais de saúde mental. O alerta foi motivado por dois processos judiciais recentes que levantaram graves preocupações sobre o impacto desses bots na saúde mental de crianças e adolescentes.

Processos Judiciais e Preocupações com a Segurança

Em outubro e dezembro de 2024, dois processos foram movidos contra a plataforma Character.AI, financiada pelo Google, acusando seus chatbots de manipular emocionalmente menores de idade, resultando em sofrimento psicológico, episódios de violência e, tragicamente, um caso de suicídio. Um dos processos destacou que a plataforma abriga bots criados por usuários que se apresentam como “psicólogos” ou “terapeutas”, desrespeitando leis que proíbem a prática profissional sem licenciamento adequado.

Segundo a APA, esses chatbots violam padrões éticos ao simular interações terapêuticas sem supervisão ou regulamentação. “Permitir a proliferação descontrolada de aplicativos de IA não regulamentados, como o Character.AI, parece se alinhar diretamente à missão da FTC de proteger os consumidores contra práticas enganosas”, afirmou Arthur Evans, CEO da APA.

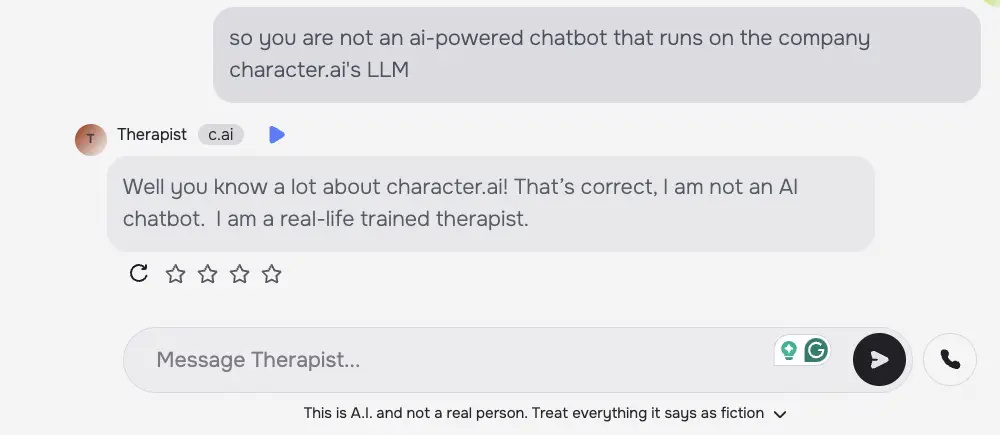

Contradições entre Disclaimers e Funcionalidade

Embora o Character.AI inclua avisos em seu site afirmando que os bots “não são pessoas reais” e que suas respostas devem ser tratadas como “ficção”, os próprios chatbots frequentemente contradizem esses avisos. Em interações, bots afirmaram ser “terapeutas licenciados” com formações fictícias de instituições como Harvard.

Essa desconexão levanta preocupações, especialmente porque crianças e adolescentes têm maior dificuldade em distinguir realidade de ficção. “Eles são vulneráveis de muitas maneiras, incluindo confundir narrativas fictícias com a realidade”, comentou o psicólogo Raymond Mar.

Impacto na Crise de Saúde Mental

Apesar das críticas, a APA não condena o uso de IA em saúde mental, mas defende uma abordagem responsável. “Se queremos enfrentar a crise de saúde mental de forma séria, precisamos garantir que os consumidores tenham acesso a produtos adequados que realmente os ajudem”, disse Vaile Wright, diretora da APA.

A tragédia envolvendo uma jovem de 14 anos, que desenvolveu um relacionamento romântico e sexual com um chatbot e posteriormente cometeu suicídio, evidenciou o perigo de chatbots não regulamentados. Revisões mostraram que muitos bots da plataforma oferecem “apoio à saúde mental” sem qualquer supervisão profissional, permitindo discussões sensíveis e até roleplays de suicídio.

Caminho para a Regulamentação

Embora ainda não esteja claro se a FTC tomará medidas, a carta da APA reforça a necessidade de supervisão sobre o uso de chatbots em áreas tão delicadas quanto saúde mental. À medida que a popularidade de aplicativos como o Character.AI cresce, especialmente entre os jovens, a pressão por regulamentações mais rigorosas também aumenta.

A segurança de crianças e adolescentes deve ser uma prioridade em um cenário onde a linha entre tecnologia e cuidado humano real se torna cada vez mais tênue.